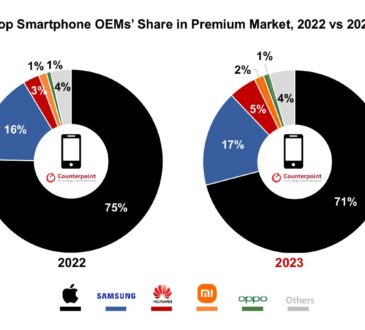

ผู้ชนะตัวจริงของสงคราม AI คือ NVIDIA ขายจีพียูเทรนโมเดลราคาแพง กินส่วนแบ่ง 95% – SMS Marketing ราคาถูกที่สุด

ท่ามกลางสงคราม AI ระหว่างบริษัทยักษ์ใหญ่ เช่น Google, Meta, Microsoft+OpenAI รวมถึงรายย่อยลงมาอย่าง Stable Diffusion ถึงแม้ยังไม่เห็นผลแพ้ชนะในเร็ววัน แต่ผู้ชนะตัวจริงอาจเป็น NVIDIA ผู้ขายจีพียูรุ่นท็อปสำหรับเทรนโมเดลขนาดใหญ่ ที่ทุกบริษัทต้องซื้อหามาใช้งาน

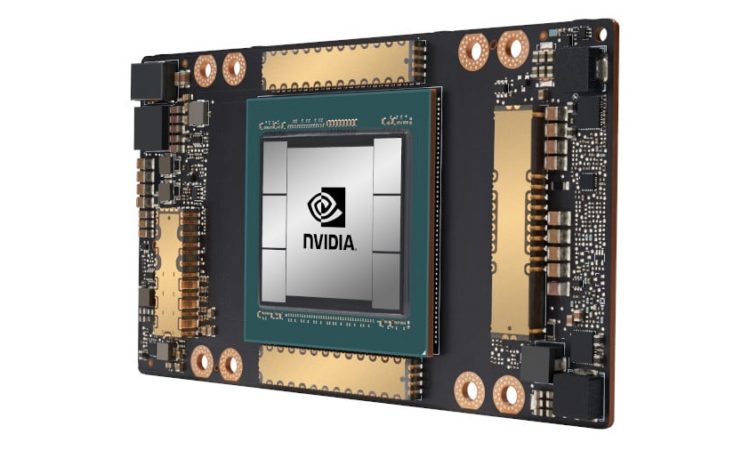

จีพียูยอดนิยมของวงการ AI คือ NVIDIA A100 ที่เปิดตัวในปี 2020 ราคาตัวละเกือบ 10,000 ดอลลาร์ เซิร์ฟเวอร์ทั้งชุด DGX A100 มีจีพียู 8 ตัว มีราคาขายราว 200,000 ดอลลาร์ คาดกันว่า NVIDIA ครองตลาดจีพียู AI ถึง 95% เรียกได้ว่าแทบไร้คู่แข่ง

ตัวอย่างลูกค้าของ NVIDIA คือบริษัท Stability AI เจ้าของโมเดล Stable Diffusion ที่ซีอีโอ Emad Mostaque เคยโพสต์ในทวิตเตอร์ว่าปีที่แล้วมี A100 จำนวน 32 ตัว ตอนนี้กำลังสะสม A100 เพิ่มขึ้น (มีรายงานประเมินว่าตอนนี้มี 5,400 ตัวแล้ว แต่ยังไม่มีตัวเลขอย่างเป็นทางการ)

A year ago we had 32 A100s 👀Dream big and stack moar GPUs kids.Brrrr

— Emad (@EMostaque) January 17, 2023

ลูกค้ารายใหญ่ของ NVIDIA คือ Meta ที่มีจีพียูถึง 16,000 ตัว, ซูเปอร์คอมพิวเตอร์ Leonardo ของรัฐบาลอิตาลี 13,800 ตัว, Tesla 7,360 ตัว เป็นต้น ตัวเลขนี้ยังไม่นับรวมผู้ให้บริการคลาวด์อย่าง Microsoft, AWS, GCP ที่มีจีพียูให้เช่าอีกจำนวนมากด้วย

มีตัวเลขประเมินจาก New Street Research ว่าโมเดล ChatGPT ของ Bing จำเป็นต้องใช้จีพียู 8 ตัวในการประมวลผลต่อหนึ่งคำถาม และไมโครซอฟท์จำเป็นต้องใช้เซิร์ฟเวอร์จีพียูทั้งหมดราว 20,000 เครื่อง (เครื่องละ 8 จีพียู) เพื่อให้บริการ Bing กับผู้ใช้ทุกคน ต้นทุนแค่ค่าเครื่องอาจสูงถึง 4 พันล้านดอลลาร์

หากไม่ใช้จีพียู NVIDIA แล้วมีทางเลือกอื่นใดบ้าง คู่แข่งในตลาดที่ชัดเจนตอนนี้เป็นสายคลาวด์ เช่น กูเกิลที่ทำ TPU ใช้เอง, AWS มีชิปออกแบบเองชื่อ Inferentia ส่วนอินเทลและ AMD ถึงแม้มีชิปแบบเดียวกัน (เช่น Intel Habana)

ในอีกทางยังมีสตาร์ตอัพที่พยายามทำชิป AI เฉพาะทาง เช่น Cerebras, Graphcore, Sambanova, Cambricon แต่ก็ยังไม่มีส่วนแบ่งตลาดมากนัก หากลองดูจากปริมาณเปเปอร์วิจัยด้าน AI ที่ระบุว่าใช้งานชิป NVIDIA มีรวมกันเกิน 21,000 ชิ้น ในขณะที่ใช้ชิปทางเลือกเพียงหลักสิบเท่านั้น

ระยะห่างในตลาดชิปอาจยิ่งกว้างไปอีก เพราะปีที่แล้ว 2022 NVIDIA เพิ่งเปิดตัวจีพียูเซิร์ฟเวอร์รุ่นใหม่ H100 สถาปัตยกรรม Hopper ที่จะเริ่มส่งมอบในปี 2023 และมีประกาศความร่วมมือกับทั้ง Meta และ Microsoft เพื่อสร้างซูเปอร์คอมพิวเตอร์สำหรับเทรน AI รุ่นใหม่ด้วย H100 และในปีนี้เราคงจะได้เห็นการใช้ชิป H100 เพิ่มขึ้นอีกมาก

ที่มา – State of AI, CNBC