รู้จัก Alpaca และ Koala โมเดล LLM ที่พัฒนาต่อจาก LLaMA ของ Meta, ขนาดเล็กกว่า GPT แต่แข่งขันได้ – SMS Marketing ราคาถูกที่สุด

ถึงแม้ OpenAI เปลี่ยนมาใช้แนวทางปิด ไม่เปิดเผยรายละเอียดของโมเดล GPT-4 และฝั่งกูเกิลเองก็ยังค่อนข้างระมัดระวังในการปล่อย Bard ทีละนิด แต่โลกเราก็ยังมีโมเดลภาษาขนาดใหญ่ (Large Language Model หรือ LLM) ตัวอื่นให้ใช้งาน โดยเฉพาะ LLaMA ของ Meta ที่เปิดตัวในเดือนกุมภาพันธ์ 2023 ซึ่งเป็นโอเพนซอร์ส ใช้สัญญาอนุญาตแบบ GPLv3 และเปิดทางให้หน่วยงานวิจัยมาขอชุดข้อมูลที่ใช้เทรนไปศึกษาได้

ตัวอย่างก่อนหน้านี้คือ Nebuly AI สร้าง ChatLLaMA แบบโอเพนซอร์ส ใช้โมเดล LLaMA ของ Meta เป็นฐาน

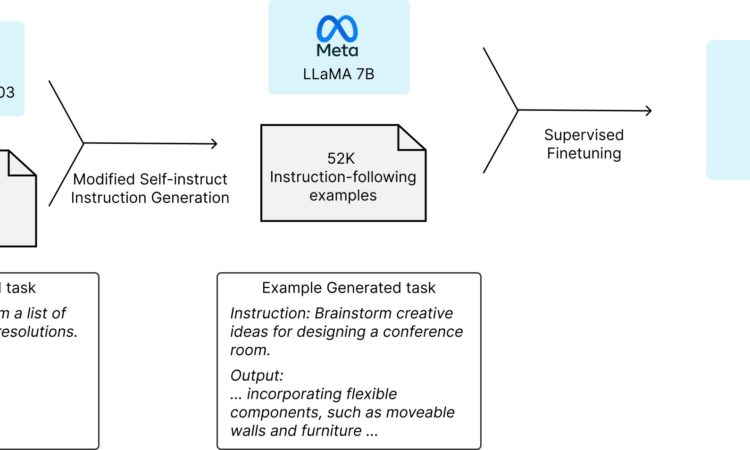

ส่วนมหาวิทยาลัยที่นำ LLaMa ไปใช้งานคือ Stanford มีโมเดลชื่อ Alpaca (ทุกคนล้วนรักสัตว์) เป็นการนำเอาโมเดล LLaMA ขนาดเล็ก 7 พันล้านพารามิเตอร์ มาเทรนปรับแต่ง (fine-tuning) อีกรอบด้วยข้อมูลการถาม-ตอบจาก OpenAI GPT (ฐานข้อมูล text-davinci-003) ช่วยให้โมเดล LLaMA ที่ขนาดเล็กกว่า GPT มาก สามารถตอบคำถามได้ไกล้เคียงกับ GPT มากขึ้น

ล่าสุด BAIR หรือ Berkeley Artificial Intelligence Research ห้องวิจัยปัญญาประดิษฐ์ของมหาวิทยาลัย UC Berkeley เปิดตัวโมเดลแชทบ็อต Koala ซึ่งเป็นการดัดแปลง LLaMA ให้ตอบคำถามได้แม่นยำขึ้น โดยไม่ต้องใช้จำนวนพารามิเตอร์มากเท่ากับ GPT-4

Koala เป็นการนำโมเดล LLaMA ขนาดใหญ่ 1.3 หมื่นล้านพารามิเตอร์ มาเทรนเพิ่ม (fine-tune) โดยใช้ข้อมูลที่หาได้จากสาธารณะ ทั้งจากบนเว็บทั่วไปและจากชุดข้อมูลเทรนที่เปิดสาธารณะอยู่แล้ว (บางส่วนเป็นชุดข้อมูลคำถามคำตอบจาก ShareGPT รวมถึงข้อมูลจาก Alpaca ด้วย) ได้ออกมาเป็นโมเดล Koala-13B ขนาดเท่าๆ เดิมกับต้นฉบับ แต่มีความแม่นยำในการตอบคำถามมากขึ้น

ผลการทดสอบโดยนำคำตอบจาก Koala มาเทียบกับโมเดลอื่นๆ ทั้ง ChatGPT และ Alpaca แล้วให้มนุษย์ 100 คนตัดสินแบบ blind test ว่าอันไหนดีกว่า (180 คำถามทดสอบ) พบว่าโมเดล Koala สามารถเอาชนะ Alpaca ได้แล้ว แต่ยังแพ้ ChatGPT อยู่ แต่ก็ถือว่าทำได้ดี แพ้ไม่ขาด ด้วยขนาดพารามิเตอร์ที่เล็กกว่ามาก

BAIR บอกว่าโมเดล Koala ที่พัฒนาต่อจาก LLaMA มีจุดอ่อนร่วมเหมือนโมเดลตระกูล LLM อื่นๆ คือ อาจเพ้อเจ้อ (hallucinate) และตอบคำถามแบบมั่วๆ อย่างมั่นใจ ซึ่งในแง่การวิจัยก็ต้องหาวิธีพัฒนาปิดจุดอ่อนตรงนี้กันต่อไป

ทั้งโมเดล Alpaca และ Koala เปิดตัวโมเดลและชุดข้อมูลเป็นโอเพนซอร์ส รายละเอียดอ่านได้จากลิงก์ของทั้งสองโครงการ